Scrapy啟動報錯invalid syntax

報錯信息

Traceback (most recent call last): File “d:pythonlib unpy.py”,

line 193, in _run_module_as_main

“main”, mod_spec) File “d:pythonlib unpy.py”, line 85, in run_code

exec(code, run_globals) File "D:pythonScriptsscrapy.exe_main.py", line 9, in File

“d:pythonlibsite-packagesscrapycmdline.py”, line 150, in execute

_run_print_help(parser, _run_command, cmd, args, opts) File “d:pythonlibsite-packagesscrapycmdline.py”, line 90, in

_run_print_help

func(*a, **kw) File “d:pythonlibsite-packagesscrapycmdline.py”, line 157, in

_run_command

cmd.run(args, opts) File “d:pythonlibsite-packagesscrapycommandscrawl.py”, line 57, in

run

self.crawler_process.crawl(spname, **opts.spargs) File “d:pythonlibsite-packagesscrapycrawler.py”, line 170, in crawl

crawler = self.create_crawler(crawler_or_spidercls) File “d:pythonlibsite-packagesscrapycrawler.py”, line 198, in

create_crawler

return self._create_crawler(crawler_or_spidercls) File “d:pythonlibsite-packagesscrapycrawler.py”, line 203, in

create_crawler

return Crawler(spidercls, self.settings) File “d:pythonlibsite-packagesscrapycrawler.py”, line 55, in init

self.extensions = ExtensionManager.from_crawler(self) File “d:pythonlibsite-packagesscrapymiddleware.py”, line 58, in

from_crawler

return cls.from_settings(crawler.settings, crawler) File “d:pythonlibsite-packagesscrapymiddleware.py”, line 34, in

from_settings

mwcls = load_object(clspath) File “d:pythonlibsite-packagesscrapyutilsmisc.py”, line 44, in

load_object

mod = import_module(module) File "d:pythonlibimportlib_init.py", line 127, in import_module

return _bootstrap._gcd_import(name[level:], package, level) File “

啟動命令如下:

scrapy crawl first_spider -o first_spider.csv

解決方法

經(jīng)過查詢發(fā)現(xiàn)async在python3.7中是保留字,因此將twistedconchmanhole.py中的async修改為isasync即可解決問題

使用scrapy做爬蟲遇到的一些坑

使用xpath和CSS遇到的一些 invalid syntax

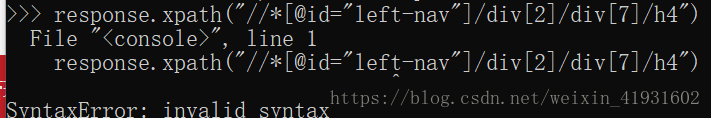

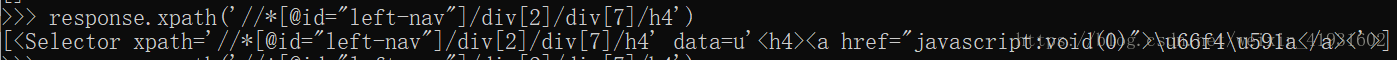

1.引號的歧義:最外面應(yīng)該使用單引號

錯誤:

正確:把定位的xpath外加單引號

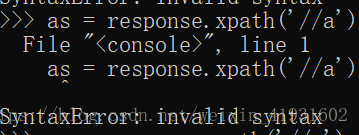

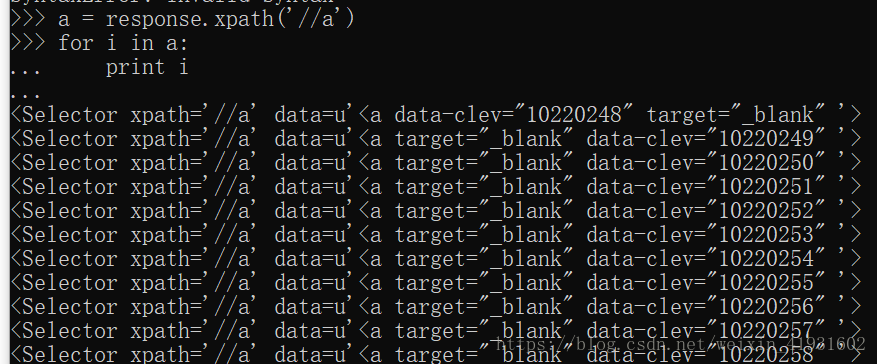

2.使用了關(guān)鍵字做變量

錯誤:

正確:注意關(guān)鍵字不能做變量

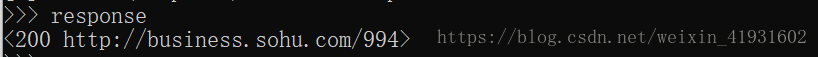

3.進(jìn)入shell窗口時,url添加了“”

錯誤:

正確:去掉url的引號

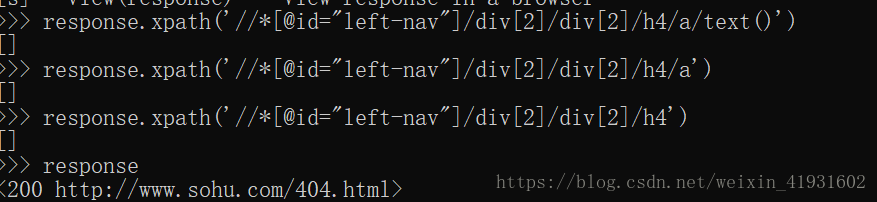

4.使用xpath匹配相關(guān)信息,返回為空列表

錯誤:因為一開始網(wǎng)址就是錯誤的,所以不管匹配的xpath是不是對的,都會返回【】

正確:

以上為個人經(jīng)驗,希望能給大家一個參考,也希望大家多多支持服務(wù)器之家。

原文鏈接:https://blog.csdn.net/weixin_43165512/article/details/105978883