除了C/C++以外,我也接觸過不少流行的語言,PHP、java、javascript、python,其中python可以說是操作起來最方便,缺點最少的語言了。

前幾天想寫爬蟲,后來跟朋友商量了一下,決定過幾天再一起寫。爬蟲里重要的一部分是抓取頁面中的鏈接,我在這里簡單的實現一下。

首先我們需要用到一個開源的模塊,requests。這不是python自帶的模塊,需要從網上下載、解壓與安裝:

$ curl -OL https://github.com/kennethreitz/requests/zipball/master

$ python setup.py install

windows用戶直接點擊下載。解壓后再本地使用命令python setup.py install安裝即可。 https://github.com/kennethreitz/requests/zipball/master

這個模塊的文檔我也正在慢慢翻譯,翻譯完了就給大家傳上來(英文版先發在附件里)。就像它的說明里面說的那樣,built for human beings,為人類而設計。使用它很方便,自己看文檔。最簡單的,requests.get()就是發送一個get請求。

代碼如下:

# coding:utf-8

import re

import requests

# 獲取網頁內容

r = requests.get('http://www.163.com')

data = r.text

# 利用正則查找所有連接

link_list =re.findall(r"(?<=href=\").+?(?=\")|(?<=href=\').+?(?=\')" ,data)

for url in link_list:

print url

首先import進re和requests模塊,re模塊是使用正則表達式的模塊。

data = requests.get('http://www.163.com'),向網易首頁提交get請求,得到一個requests對象r,r.text就是獲得的網頁源代碼,保存在字符串data中。

再利用正則查找data中所有的鏈接,我的正則寫的比較粗糙,直接把href=""或href=''之間的信息獲取到,這就是我們要的鏈接信息。

re.findall返回的是一個列表,用for循環遍歷列表并輸出:

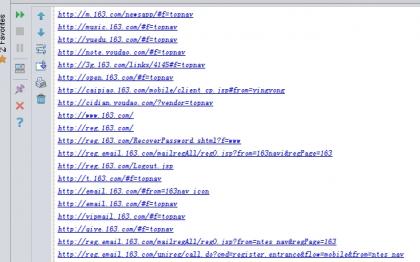

這是我獲取到的所有連接的一部分。

上面是獲取網站里所有鏈接的一個簡單的實現,沒有處理任何異常,沒有考慮到超鏈接的類型,代碼僅供參考。requests模塊文檔見附件。