什么是Scrapy?

Scrapy是一個(gè)為了爬取網(wǎng)站數(shù)據(jù),提取結(jié)構(gòu)性數(shù)據(jù)而編寫的應(yīng)用框架,非常出名,非常強(qiáng)悍。所謂的框架就是一個(gè)已經(jīng)被集成了各種功能(高性能異步下載,隊(duì)列,分布式,解析,持久化等)的具有很強(qiáng)通用性的項(xiàng)目模板。對(duì)于框架的學(xué)習(xí),重點(diǎn)是要學(xué)習(xí)其框架的特性、各個(gè)功能的用法即可。

一、背景

在做爬蟲項(xiàng)目的過程中遇到ip代理的問題,網(wǎng)上搜了一些,要么是用阿里云的ip代理,要么是搜一些網(wǎng)上現(xiàn)有的ip資源,然后配置在setting文件中。這兩個(gè)方法都存在一些問題。

1、阿里云ip代理方法,網(wǎng)上大都是配置阿里云的ip代理的用戶名、密碼然后加密、解密。我按照上面的方面操作,發(fā)現(xiàn)阿里云上面的ip代理的參數(shù)里面沒有用戶名、密碼相關(guān)的參數(shù)配置了。

2、至于網(wǎng)上查到的另外一種方法是在setting文件里面添加代理IP資源池,然后再在middlewares.py文件里面添加上一些代碼來實(shí)現(xiàn),但代理ip不一定是可用的。

二、改進(jìn)方法

1、基于背景中提到的網(wǎng)上兩種方法的局限性,我在此綜合了兩種方法。

2、改進(jìn)方法:

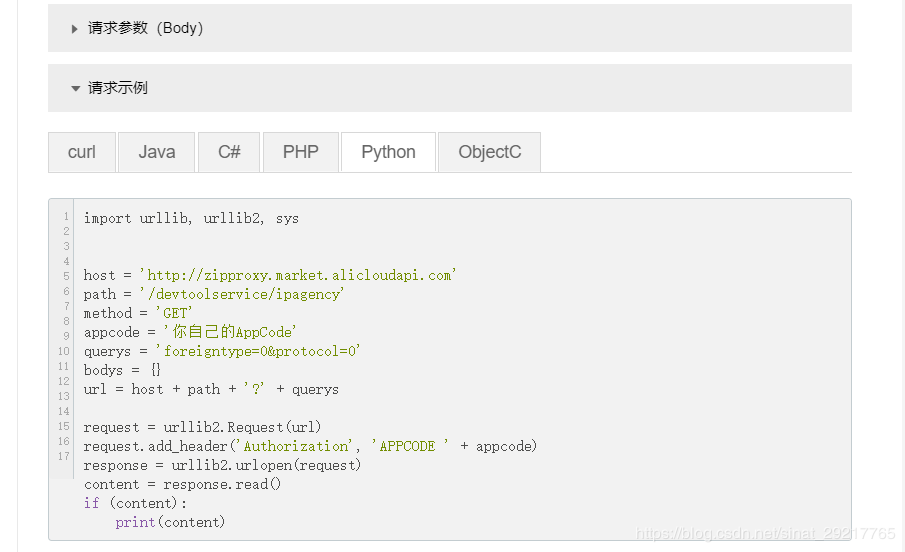

1)利用阿里云的ip代理API生成50個(gè)代理IP資源池(用自己的阿里云賬號(hào)登陸生成的,ip有效性得到保障)

2)直接在middlewares.py中添加如下函數(shù),PROXIES為在阿里云上面生成的ip,此處涉及到個(gè)人隱私,故用****代替。

|

1

2

3

4

5

|

class my_proxy(object): def process_request(self, request, spider): PROXIES = ['http://****.****.****.****:8080'] ip = random.choice(PROXIES) request.meta['Proxy-Authorization'] = ip |

注意:request.meta的方括號(hào)里面的關(guān)鍵字需要寫對(duì),不然無法正常運(yùn)行。

總結(jié)

以上所述是小編給大家介紹的python3 Scrapy爬蟲框架ip代理配置的方法,希望對(duì)大家有所幫助,如果大家有任何疑問請(qǐng)給我留言,小編會(huì)及時(shí)回復(fù)大家的。在此也非常感謝大家對(duì)服務(wù)器之家網(wǎng)站的支持!

如果你覺得本文對(duì)你有幫助,歡迎轉(zhuǎn)載,煩請(qǐng)注明出處,謝謝!

原文鏈接:https://blog.csdn.net/sinat_29217765/article/details/103994307