tf.nn.bidirectional_dynamic_rnn()

函數(shù):

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

def bidirectional_dynamic_rnn( cell_fw, # 前向RNN cell_bw, # 后向RNN inputs, # 輸入 sequence_length=None,# 輸入序列的實際長度(可選,默認為輸入序列的最大長度) initial_state_fw=None, # 前向的初始化狀態(tài)(可選) initial_state_bw=None, # 后向的初始化狀態(tài)(可選) dtype=None, # 初始化和輸出的數(shù)據(jù)類型(可選) parallel_iterations=None, swap_memory=False, time_major=False, # 決定了輸入輸出tensor的格式:如果為true, 向量的形狀必須為 `[max_time, batch_size, depth]`. # 如果為false, tensor的形狀必須為`[batch_size, max_time, depth]`. scope=None) |

其中,

outputs為(output_fw, output_bw),是一個包含前向cell輸出tensor和后向cell輸出tensor組成的元組。假設

time_major=false,tensor的shape為[batch_size, max_time, depth]。實驗中使用tf.concat(outputs, 2)將其拼接。

output_states為(output_state_fw, output_state_bw),包含了前向和后向最后的隱藏狀態(tài)的組成的元組。

output_state_fw和output_state_bw的類型為LSTMStateTuple。

LSTMStateTuple由(c,h)組成,分別代表memory cell和hidden state。

返回值:

|

1

|

元組:(outputs, output_states) |

這里還有最后的一個小問題,output_states是一個元組的元組,處理方法是用c_fw,h_fw = output_state_fw和c_bw,h_bw = output_state_bw,最后再分別將c和h狀態(tài)concat起來,用tf.contrib.rnn.LSTMStateTuple()函數(shù)生成decoder端的初始狀態(tài)

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

def encoding_layer(rnn_size,sequence_length,num_layers,rnn_inputs,keep_prob): # rnn_size: rnn隱層節(jié)點數(shù)量 # sequence_length: 數(shù)據(jù)的序列長度 # num_layers:堆疊的rnn cell數(shù)量 # rnn_inputs: 輸入tensor # keep_prob: '''Create the encoding layer''' for layer in range(num_layers): with tf.variable_scope('encode_{}'.format(layer)): cell_fw = tf.contrib.rnn.LSTMCell(rnn_size,initializer=tf.random_uniform_initializer(-0.1,0.1,seed=2)) cell_fw = tf.contrib.rnn.DropoutWrapper(cell_fw,input_keep_prob=keep_prob) cell_bw = tf.contrib.rnn.LSTMCell(rnn_size,initializer=tf.random_uniform_initializer(-0.1,0.1,seed=2)) cell_bw = tf.contrib.rnn.DropoutWrapper(cell_bw,input_keep_prob = keep_prob) enc_output,enc_state = tf.nn.bidirectional_dynamic_rnn(cell_fw,cell_bw, rnn_inputs,sequence_length,dtype=tf.float32) # join outputs since we are using a bidirectional RNN enc_output = tf.concat(enc_output,2) return enc_output,enc_state |

tf.nn.dynamic_rnn()

tf.nn.dynamic_rnn的返回值有兩個:outputs和state

為了描述輸出的形狀,先介紹幾個變量,batch_size是輸入的這批數(shù)據(jù)的數(shù)量,max_time就是這批數(shù)據(jù)中序列的最長長度,如果輸入的三個句子,那max_time對應的就是最長句子的單詞數(shù)量,cell.output_size其實就是rnn cell中神經(jīng)元的個數(shù)。

例子來說明其用法,假設你的RNN的輸入input是[2,20,128],其中2是batch_size,20是文本最大長度,128是embedding_size,可以看出,有兩個example,我們假設第二個文本長度只有13,剩下的7個是使用0-padding方法填充的。dynamic返回的是兩個參數(shù):outputs,state,其中outputs是[2,20,128],也就是每一個迭代隱狀態(tài)的輸出,state是由(c,h)組成的tuple,均為[batch,128]。

outputs. outputs是一個tensor

如果time_major==True,outputs形狀為 [max_time, batch_size, cell.output_size ](要求rnn輸入與rnn輸出形狀保持一致)

如果time_major==False(默認),outputs形狀為 [ batch_size, max_time, cell.output_size ]

state. state是一個tensor。state是最終的狀態(tài),也就是序列中最后一個cell輸出的狀態(tài)。一般情況下state的形狀為 [batch_size, cell.output_size ],但當輸入的cell為BasicLSTMCell時,state的形狀為[2,batch_size, cell.output_size ],其中2也對應著LSTM中的cell state和hidden state。

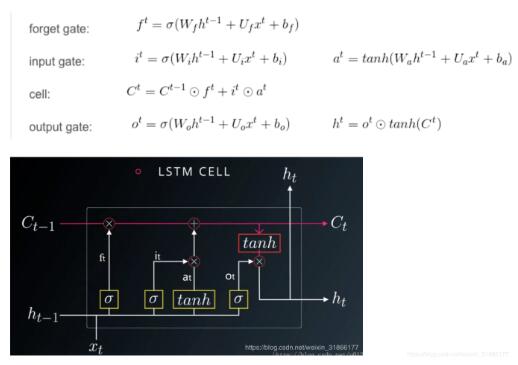

這里有關于LSTM的結(jié)構(gòu)問題:

以上這篇淺談Tensorflow 動態(tài)雙向RNN的輸出問題就是小編分享給大家的全部內(nèi)容了,希望能給大家一個參考,也希望大家多多支持服務器之家。

原文鏈接:https://blog.csdn.net/weixin_31866177/article/details/81905226