一.配置版本

Java JDK 1.8.0_111

Python 3.9.6

Spark 3.1.2

Hadoop 3.2.2

二.配置環(huán)境

1.配置JDK

從官網(wǎng)下載相應(yīng)JDK的版本安裝,并進(jìn)行環(huán)境變量的配置

(1)在系統(tǒng)變量新建JAVA_HOME,根據(jù)你安裝的位置填寫(xiě)變量值

(2)新建CLASSPATH

變量值:.;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar;(注意前面所需的符號(hào))

(3)點(diǎn)擊Path

在其中進(jìn)行新建:%JAVA_HOME%\bin

(4)配置好后進(jìn)行確定

(5)驗(yàn)證,打開(kāi)cmd,輸入java -version和javac進(jìn)行驗(yàn)證

此上說(shuō)明jdk環(huán)境變量配置成功

2.配置Spark

(1)下載安裝:

Spark官網(wǎng):spark-3.1.2-bin-hadoop3.2下載地址

(2)解壓,配置環(huán)境

(3)點(diǎn)擊Path,進(jìn)行新建:%SPARK_HOME%\bin,并確認(rèn)

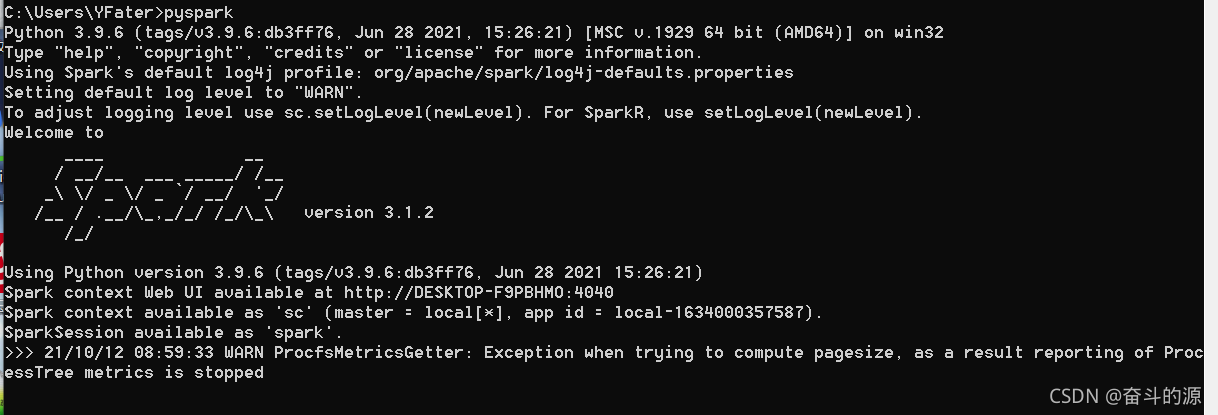

(4)驗(yàn)證,cmd中輸入pyspark

這里提醒我們要安裝Hadoop

3.配置Hadoop

(1)下載:

Hadoop官網(wǎng):Hadoop 3.2.2下載地址

(2)解壓,配置環(huán)境

注意:解壓文件后,bin文件夾中可能沒(méi)有以下兩個(gè)文件:

下載地址:https://github.com/cdarlint/winutils

配置環(huán)境變量CLASSPATH:%HADOOP_HOME%\bin\winutils.exe

(3)點(diǎn)擊Path,進(jìn)行新建:%HADOOP_HOME%\bin,并確認(rèn)

(4)驗(yàn)證,cmd中輸入pyspark

由上可以看出spark能運(yùn)行成功,但是會(huì)出現(xiàn)如下警告:

WARN ProcfsMetricsGetter: Exception when trying to compute pagesize, as a result reporting of ProcessTree metrics is stopped

這里因?yàn)閟park為3.x版本有相關(guān)改動(dòng),使用spar2.4.6版本不會(huì)出現(xiàn)這樣的問(wèn)題。

不改版本解決方式(因是警告,未嘗試):

方式一:解決方法一

方式二:解決方法二

三.Pycharm配置spark

(1)RunC>Edit Configurations

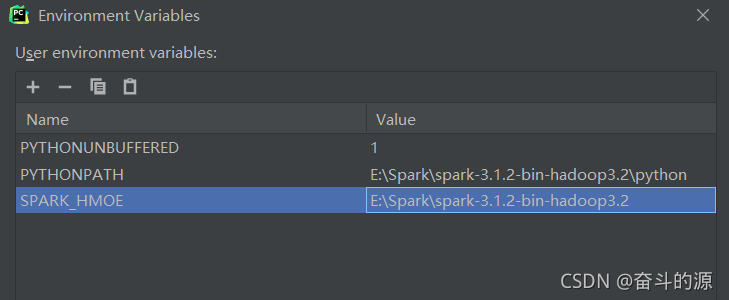

(2)對(duì)Environment Variables進(jìn)行配置

(3)FileC>SettingsC>Project StructureC>Add Content Root

找到spark-3.1.2-bin-hadoop3.2\python\lib下兩個(gè)包進(jìn)行添加

選擇結(jié)果:

(4)測(cè)試

# 添加此代碼,進(jìn)行spark初始化 import findspark findspark.init() from datetime import datetime, date from pyspark.sql import SparkSession spark = SparkSession.builder.getOrCreate() rdd = spark.sparkContext.parallelize([ (1, 2., 'string1', date(2000, 1, 1), datetime(2000, 1, 1, 12, 0)), (2, 3., 'string2', date(2000, 2, 1), datetime(2000, 1, 2, 12, 0)), (3, 4., 'string3', date(2000, 3, 1), datetime(2000, 1, 3, 12, 0)) ]) df = spark.createDataFrame(rdd, schema=['a', 'b', 'c', 'd', 'e']) df.show()

運(yùn)行結(jié)果:

四.使用anconda中python環(huán)境配置spark

1.創(chuàng)建虛擬環(huán)境

conda create -n pyspark_env python==3.9.6

查看環(huán)境:

conda env list

運(yùn)行結(jié)果:

2.安裝pyspark

切換到pyspark_env并進(jìn)行安裝pyspark

pip install pyspark

3.環(huán)境配置

運(yùn)行上面的實(shí)例,會(huì)出現(xiàn)以下錯(cuò)誤:

這說(shuō)明我們需要配置py4j,SPARK_HOME

SPARK_HOME:

PYTHONPATH設(shè)置:

HADOOP_HOME設(shè)置:

path中設(shè)置:

4.運(yùn)行

# 添加此代碼,進(jìn)行spark初始化 import findspark findspark.init() from datetime import datetime, date from pyspark.sql import SparkSession spark = SparkSession.builder.getOrCreate() rdd = spark.sparkContext.parallelize([ (1, 2., 'string1', date(2000, 1, 1), datetime(2000, 1, 1, 12, 0)), (2, 3., 'string2', date(2000, 2, 1), datetime(2000, 1, 2, 12, 0)), (3, 4., 'string3', date(2000, 3, 1), datetime(2000, 1, 3, 12, 0)) ]) df = spark.createDataFrame(rdd, schema=['a', 'b', 'c', 'd', 'e']) df.show()

運(yùn)行結(jié)果同上

到此這篇關(guān)于Python安裝spark的文章就介紹到這了,更多相關(guān)Python安裝spark內(nèi)容請(qǐng)搜索服務(wù)器之家以前的文章或繼續(xù)瀏覽下面的相關(guān)文章希望大家以后多多支持服務(wù)器之家!

原文鏈接:https://blog.csdn.net/yuanfate/article/details/120706537