這篇文章是擼主要介紹人臉識別經典方法的第一篇,后續會有其他方法更新。特征臉方法基本是將人臉識別推向真正可用的第一種方法,了解一下還是很有必要的。特征臉用到的理論基礎pca在另一篇博客里:特征臉(eigenface)理論基礎-pca(主成分分析法) 。本文的參考資料附在最后了^_^

步驟一:獲取包含m張人臉圖像的集合s。在我們的例子里有25張人臉圖像(雖然是25個不同人的人臉的圖像,但是看著怎么不像呢,難道我有臉盲癥么),如下圖所示哦。每張圖像可以轉換成一個n維的向量(是的,沒錯,一個像素一個像素的排成一行就好了,至于是橫著還是豎著獲取原圖像的像素,隨你自己,只要前后統一就可以),然后把這m個向量放到一個集合s里,如下式所示。

步驟二:在獲取到人臉向量集合s后,計算得到平均圖像ψ,至于怎么計算平均圖像,公式在下面。就是把集合s里面的向量遍歷一遍進行累加,然后取平均值。得到的這個ψ其實還挺有意思的,ψ其實也是一個n維向量,如果再把它還原回圖像的形式的話,可以得到如下的“平均臉”,是的沒錯,還他媽的挺帥啊。那如果你想看一下某計算機學院男生平均下來都長得什么樣子,用上面的方法就可以了。

步驟三:計算每張圖像和平均圖像的差值φ,就是用s集合里的每個元素減去步驟二中的平均值。

步驟四:找到m個正交的單位向量un,這些單位向量其實是用來描述φ(步驟三中的差值)分布的。un里面的第k(k=1,2,3...m)個向量uk是通過下式計算的,

當這個λk(原文里取了個名字叫特征值)取最小的值時,uk基本就確定了。補充一下,剛才也說了,這m個向量是相互正交而且是單位長度的,所以啦,uk還要滿足下式:

上面的等式使得uk為單位正交向量。計算上面的uk其實就是計算如下協方差矩陣的特征向量:

其中

對于一個nxn(比如100x100)維的圖像來說,上述直接計算其特征向量計算量實在是太大了(協方差矩陣可以達到10000x10000),所以有了如下的簡單計算。

步驟四另解:如果訓練圖像的數量小于圖像的維數比如(m<n^2),那么起作用的特征向量只有m-1個而不是n^2個(因為其他的特征向量對應的特征值為0),所以求解特征向量我們只需要求解一個nxn的矩陣。這個矩陣就是步驟四中的aat,我們可以設該矩陣為l,那么l的第m行n列的元素可以表示為:

一旦我們找到了l矩陣的m個特征向量vl,那么協方差矩陣的特征向量ul就可以表示為:

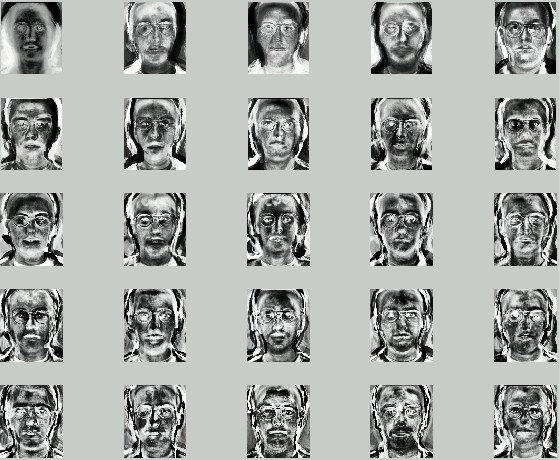

這些特征向量如果還原成像素排列的話,其實還蠻像人臉的,所以稱之為特征臉(如下圖)。圖里有二十五個特征臉,數量上和訓練圖像相等只是巧合。有論文表明一般的應用40個特征臉已經足夠了。論文eigenface for recognition里只用了7個特征臉來表明實驗。

步驟五:識別人臉。ok,終于到這步了,別繞暈啦,上面幾步是為了對人臉進行降維找到表征人臉的合適向量的。首先考慮一張新的人臉,我們可以用特征臉對其進行標示:

其中k=1,2...m,對于第k個特征臉uk,上式可以計算其對應的權重,m個權重可以構成一個向量:

perfect,這就是求得的特征臉對人臉的表示了!

那如何對人臉進行識別呢,看下式:

其中ω代表要判別的人臉,ωk代表訓練集內的某個人臉,兩者都是通過特征臉的權重來表示的。式子是對兩者求歐式距離,當距離小于閾值時說明要判別的臉和訓練集內的第k個臉是同一個人的。當遍歷所有訓練集都大于閾值時,根據距離值的大小又可分為是新的人臉或者不是人臉的兩種情況。根據訓練集的不同,閾值設定并不是固定的。

后續會有對pca理論的補充^_^.已補充理論:特征臉(eigenface)理論基礎-pca(主成分分析法)

參考資料:

1、eigenface for recognition

2、特征臉維基百科

3、eigenface_tutorial

以上就是本文的全部內容,希望對大家的學習有所幫助,也希望大家多多支持服務器之家。

原文鏈接:http://blog.csdn.net/smartempire/article/details/21406005