算法優缺點:

優點:容易實現

缺點:可能收斂到局部最小值,在大規模數據集上收斂較慢

使用數據類型:數值型數據

算法思想

k-means算法實際上就是通過計算不同樣本間的距離來判斷他們的相近關系的,相近的就會放到同一個類別中去。

1.首先我們需要選擇一個k值,也就是我們希望把數據分成多少類,這里k值的選擇對結果的影響很大,Ng的課說的選擇方法有兩種一種是elbow method,簡單的說就是根據聚類的結果和k的函數關系判斷k為多少的時候效果最好。另一種則是根據具體的需求確定,比如說進行襯衫尺寸的聚類你可能就會考慮分成三類(L,M,S)等

2.然后我們需要選擇最初的聚類點(或者叫質心),這里的選擇一般是隨機選擇的,代碼中的是在數據范圍內隨機選擇,另一種是隨機選擇數據中的點。這些點的選擇會很大程度上影響到最終的結果,也就是說運氣不好的話就到局部最小值去了。這里有兩種處理方法,一種是多次取均值,另一種則是后面的改進算法(bisecting K-means)

3.終于我們開始進入正題了,接下來我們會把數據集中所有的點都計算下與這些質心的距離,把它們分到離它們質心最近的那一類中去。完成后我們則需要將每個簇算出平均值,用這個點作為新的質心。反復重復這兩步,直到收斂我們就得到了最終的結果。

函數

loadDataSet(fileName)

從文件中讀取數據集

distEclud(vecA, vecB)

計算距離,這里用的是歐氏距離,當然其他合理的距離都是可以的

randCent(dataSet, k)

隨機生成初始的質心,這里是雖具選取數據范圍內的點

kMeans(dataSet, k, distMeas=distEclud, createCent=randCent)

kmeans算法,輸入數據和k值。后面兩個事可選的距離計算方式和初始質心的選擇方式

show(dataSet, k, centroids, clusterAssment)

可視化結果

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

|

#coding=utf-8from numpy import *def loadDataSet(fileName): dataMat = [] fr = open(fileName) for line in fr.readlines(): curLine = line.strip().split('\t') fltLine = map(float, curLine) dataMat.append(fltLine) return dataMat#計算兩個向量的距離,用的是歐幾里得距離def distEclud(vecA, vecB): return sqrt(sum(power(vecA - vecB, 2)))#隨機生成初始的質心(ng的課說的初始方式是隨機選K個點) def randCent(dataSet, k): n = shape(dataSet)[1] centroids = mat(zeros((k,n))) for j in range(n): minJ = min(dataSet[:,j]) rangeJ = float(max(array(dataSet)[:,j]) - minJ) centroids[:,j] = minJ + rangeJ * random.rand(k,1) return centroidsdef kMeans(dataSet, k, distMeas=distEclud, createCent=randCent): m = shape(dataSet)[0] clusterAssment = mat(zeros((m,2)))#create mat to assign data points #to a centroid, also holds SE of each point centroids = createCent(dataSet, k) clusterChanged = True while clusterChanged: clusterChanged = False for i in range(m):#for each data point assign it to the closest centroid minDist = inf minIndex = -1 for j in range(k): distJI = distMeas(centroids[j,:],dataSet[i,:]) if distJI < minDist: minDist = distJI; minIndex = j if clusterAssment[i,0] != minIndex: clusterChanged = True clusterAssment[i,:] = minIndex,minDist**2 print centroids for cent in range(k):#recalculate centroids ptsInClust = dataSet[nonzero(clusterAssment[:,0].A==cent)[0]]#get all the point in this cluster centroids[cent,:] = mean(ptsInClust, axis=0) #assign centroid to mean return centroids, clusterAssmentdef show(dataSet, k, centroids, clusterAssment): from matplotlib import pyplot as plt numSamples, dim = dataSet.shape mark = ['or', 'ob', 'og', 'ok', '^r', '+r', 'sr', 'dr', '<r', 'pr'] for i in xrange(numSamples): markIndex = int(clusterAssment[i, 0]) plt.plot(dataSet[i, 0], dataSet[i, 1], mark[markIndex]) mark = ['Dr', 'Db', 'Dg', 'Dk', '^b', '+b', 'sb', 'db', '<b', 'pb'] for i in range(k): plt.plot(centroids[i, 0], centroids[i, 1], mark[i], markersize = 12) plt.show()def main(): dataMat = mat(loadDataSet('testSet.txt')) myCentroids, clustAssing= kMeans(dataMat,4) print myCentroids show(dataMat, 4, myCentroids, clustAssing) if __name__ == '__main__': main() |

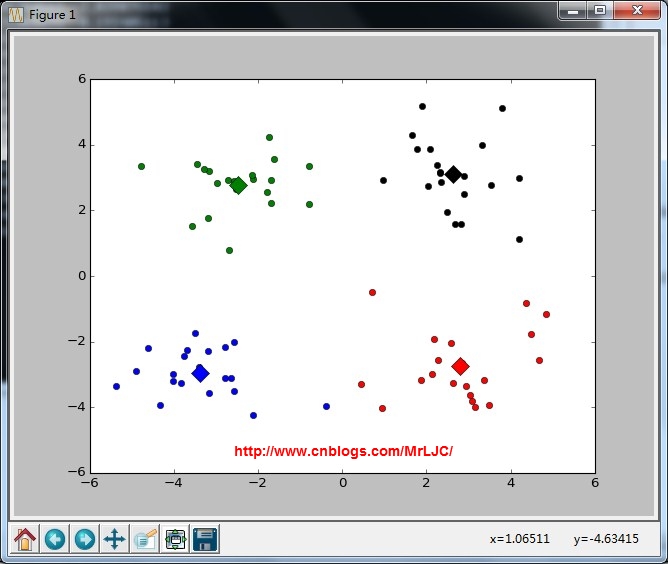

這里是聚類結果,還是很不錯的啦

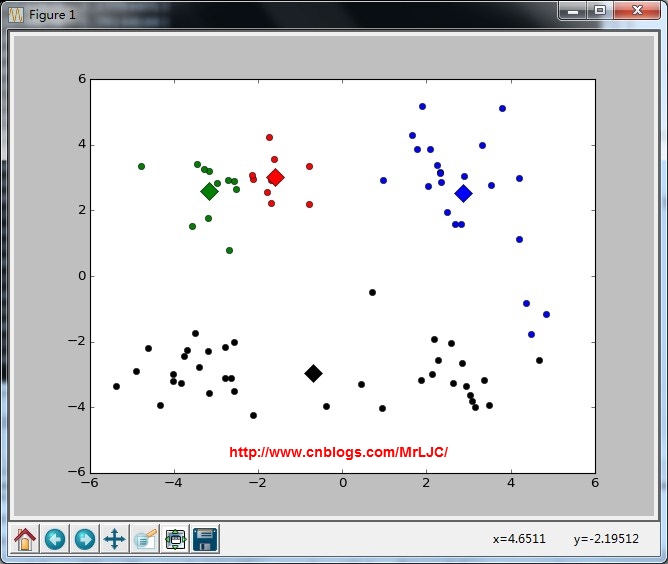

但是有時候也會收斂到局部最小值,就像下面這樣,就是不幸收斂到局部最優了

總結

以上就是本文關于python中實現k-means聚類算法詳解的全部內容,希望對大家有所幫助。有什么問題可以隨時留言,小編會及時回復大家的。感謝朋友們對本站的支持!

原文鏈接:http://www.cnblogs.com/MrLJC/p/4127553.html