這一篇網絡爬蟲的實現就要聯系上大數據了。在前兩篇java實現網絡爬蟲和heritrix實現網絡爬蟲的基礎上,這一次是要完整的做一次數據的收集、數據上傳、數據分析、數據結果讀取、數據可視化。

需要用到

cygwin:一個在windows平臺上運行的類unix模擬環境,直接網上搜索下載,并且安裝;

hadoop:配置hadoop環境,實現了一個分布式文件系統(hadoop distributed file system),簡稱hdfs,用來將收集的數據直接上傳保存到hdfs,然后用mapreduce分析;

eclipse:編寫代碼,需要導入hadoop的jar包,以可以創建mapreduce項目;

jsoup:html的解析jar包,結合正則表達式能更好的解析網頁源碼;

----->

目錄:

1、配置cygwin

2、配置hadoop黃靜

3、eclipse開發環境搭建

4、網絡數據爬取(jsoup)

-------->

1、安裝配置cygwin

從官方網站下載cygwin 安裝文件,地址:https://cygwin.com/install.html

下載運行后進入安裝界面。

安裝時直接從網絡鏡像中下載擴展包,至少需要選擇ssh和ssl支持包

安裝后進入cygwin控制臺界面,

運行ssh-host-config命令,安裝ssh

輸入:no,yes,ntsec,no,no

注意:win7下需要改為yes,yes,ntsec,no,yes,輸入密碼并確認這個步驟

完成后會在windows操作系統中配置好一個cygwin sshd服務,啟動該服務即可。

然后要配置ssh免密碼登陸

重新運行cygwin。

執行ssh localhost,會要求使用密碼進行登陸。

使用ssh-keygen命令來生成一個ssh密鑰,一直回車結束即可。

生成后進入.ssh目錄,使用命令:cp id_rsa.pub authorized_keys 命令來配置密鑰。

之后使用exit退出即可。

重新進入系統后,通過ssh localhost就可以直接進入系統,不需要再輸入密碼了。

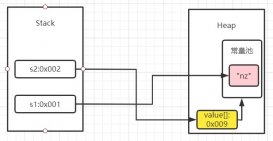

2、配置hadoop環境

修改hadoop-env.sh文件,加入jdk安裝目錄的java_home位置設置。

|

1

2

3

4

|

# the java implementation to use. required.export java_home=/cygdrive/c/java/jdk1.7.0_67 |

如圖注意:program files縮寫為progra~1

![]()

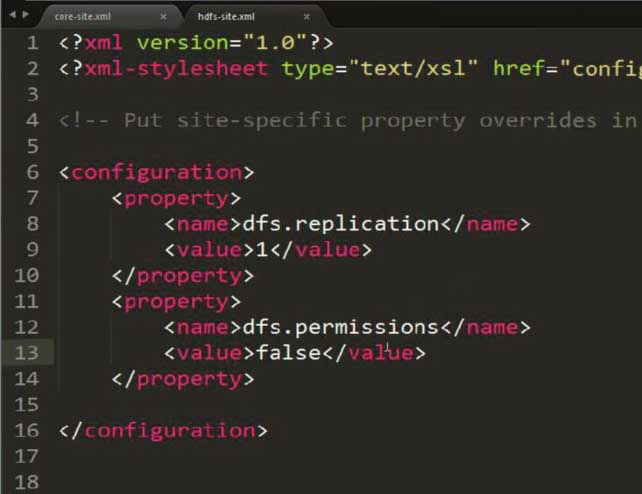

修改hdfs-site.xml,設置存放副本為1(因為配置的是偽分布式方式)

|

1

2

3

4

5

6

|

<configuration><property><name>dfs.replication</name><value>1</value></property></configuration> |

注意:此圖片多加了一個property,內容就是解決可能出現的權限問題!!!

hdfs:hadoop 分布式文件系統

可以在hdfs中通過命令動態對文件或文件夾進行crud

注意有可能出現權限的問題,需要通過在hdfs-site.xml中配置以下內容來避免:

|

1

2

3

4

|

<property><name>dfs.permissions</name><value>false</value></property> |

修改mapred-site.xml,設置jobtracker運行的服務器與端口號(由于當前就是運行在本機上,直接寫localhost 即可,端口可以綁定任意空閑端口)

|

1

2

3

4

5

6

|

<configuration><property><name>mapred.job.tracker</name><value>localhost:9001</value></property></configuration> |

配置core-site.xml,配置hdfs文件系統所對應的服務器與端口號(同樣就在當前主機)

|

1

2

3

4

5

6

|

<configuration><property><name>fs.default.name</name><value>hdfs://localhost:9000</value></property></configuration> |

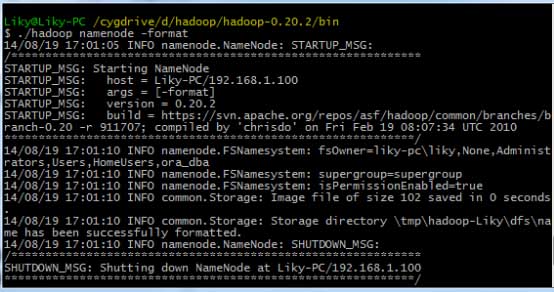

配置好以上內容后,在cygwin中進入hadoop目錄

在bin目錄下,對hdfs文件系統進行格式化(第一次使用前必須格式化),然后輸入啟動命令:

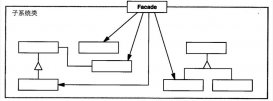

3、eclipse開發環境搭建

這個在我寫的博客 大數據【二】hdfs部署及文件讀寫(包含eclipse hadoop配置)中給出大致配置方法。不過此時需要完善一下。

將hadoop中的hadoop-eclipse-plugin.jar支持包拷貝到eclipse的plugin目錄下,為eclipse添加hadoop支持。

啟動eclipse后,切換到mapreduce界面。

在windows工具選項選擇showviews的others里面查找map/reduce locations。

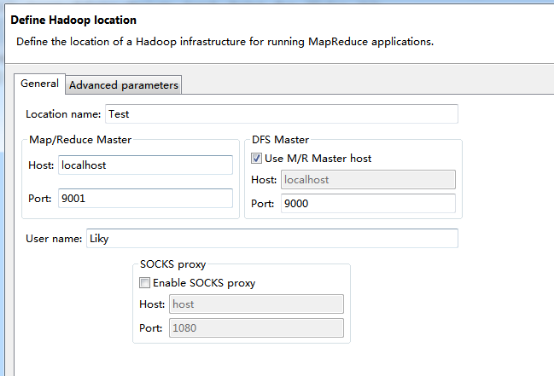

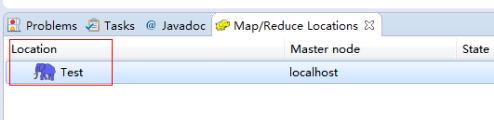

在map/reduce locations窗口中建立一個hadoop location,以便與hadoop進行關聯。

注意:此處的兩個端口應為你配置hadoop的時候設置的端口!!!

完成后會建立好一個hadoop location

在左側的dfs location中,還可以看到hdfs中的各個目錄

并且你可以在其目錄下自由創建文件夾來存取數據。

下面你就可以創建mapreduce項目了,方法同正常創建一樣。

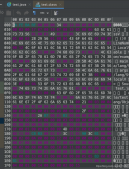

4、網絡數據爬取

現在我們通過編寫一段程序,來將爬取的新聞內容的有效信息保存到hdfs中。

此時就有了兩種網絡爬蟲的方法:

其一就是利用heritrix工具獲取的數據;

其一就是java代碼結合jsoup編寫的網絡爬蟲。

方法一的信息保存到hdfs:

直接讀取生成的本地文件,用jsoup解析html,此時需要將jsoup的jar包導入到項目中。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

|

package org.liky.sina.save;//這里用到了jsoup開發包,該包可以很簡單的提取到html中的有效信息import java.io.file;import org.apache.hadoop.conf.configuration;import org.apache.hadoop.fs.fsdataoutputstream;import org.apache.hadoop.fs.filesystem;import org.apache.hadoop.fs.path;import org.jsoup.jsoup;import org.jsoup.nodes.document;import org.jsoup.nodes.element;import org.jsoup.select.elements;public class sinanewsdata { private static configuration conf = new configuration(); private static filesystem fs; private static path path; private static int count = 0; public static void main(string[] args) { parseallfile(new file( "e:/heritrix-1.12.1/jobs/sina_news_job_02-20170814013255352/mirror/")); } public static void parseallfile(file file) { // 判斷類型 if (file.isdirectory()) { // 文件夾 file[] allfile = file.listfiles(); if (allfile != null) { for (file f : allfile) { parseallfile(f); } } } else { // 文件 if (file.getname().endswith(".html") || file.getname().endswith(".shtml")) { parsecontent(file.getabsolutepath()); } } } public static void parsecontent(string filepath) { try { //用jsoup的方法讀取文件路徑 document doc = jsoup.parse(new file(filepath), "utf-8"); //讀取標題 string title = doc.title(); elements descelem = doc.getelementsbyattributevalue("name", "description"); element desce = descelem.first(); // 讀取內容 string content = desce.attr("content"); if (title != null && content != null) { //通過path來保存數據到hdfs中 path = new path("hdfs://localhost:9000/input/" + system.currenttimemillis() + ".txt"); fs = path.getfilesystem(conf); // 建立輸出流對象 fsdataoutputstream os = fs.create(path); // 使用os完成輸出 os.writechars(title + "\r\n" + content); os.close(); count++; system.out.println("已經完成" + count + " 個!"); } } catch (exception e) { e.printstacktrace(); } }} |

以上這篇hadoop中實現java網絡爬蟲(示例講解)就是小編分享給大家的全部內容了,希望能給大家一個參考,也希望大家多多支持服務器之家。

原文鏈接:http://www.cnblogs.com/1996swg/p/7368277.html