網絡爬蟲(又被稱為網頁蜘蛛,網絡機器人,在FOAF社區中間,更經常被稱為網頁追逐者),是一種按照一定的規則,自動的抓取萬維網信息的程序或者腳本,已被廣泛應用于互聯網領域。搜索引擎使用網絡爬蟲抓取Web網頁、文檔甚至圖片、音頻、視頻等資源,通過相應的索引技術組織這些信息,提供給搜索用戶進行查詢。網絡爬蟲也為中小站點的推廣提供了有效的途徑,網站針對搜索引擎爬蟲的優化曾風靡一時。

網絡爬蟲的基本工作流程如下:

1.首先選取一部分精心挑選的種子URL;

2.將這些URL放入待抓取URL隊列;

3.從待抓取URL隊列中取出待抓取在URL,解析DNS,并且得到主機的ip,并將URL對應的網頁下載下來,存儲進已下載網頁庫中。此外,將這些URL放進已抓取URL隊列。

4.分析已抓取URL隊列中的URL,分析其中的其他URL,并且將URL放入待抓取URL隊列,從而進入下一個循環。

當然,上面說的那些我都不懂,以我現在的理解,我們請求一個網址,服務器返回給我們一個超級大文本,而我們的瀏覽器可以將這個超級大文本解析成我們說看到的華麗的頁面

那么,我們只需要把這個超級大文本看成一個足夠大的String 字符串就OK了。

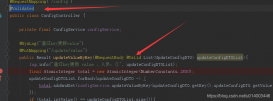

下面是我的代碼

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

package main.spider;import org.jsoup.Jsoup;import org.jsoup.nodes.Document;import org.jsoup.nodes.Element;import org.jsoup.select.Elements;import java.io.IOException;/** * Created by 1755790963 on 2017/3/10. */public class Second { public static void main(String[] args) throws IOException { System.out.println("begin"); Document document = Jsoup.connect("http://tieba.baidu.com/p/2356694991").get(); String selector="div[class=d_post_content j_d_post_content clearfix]"; Elements elements = document.select(selector); for (Element element:elements){ String word= element.text(); if(word.indexOf("@")>0){ word=word.substring(0,word.lastIndexOf("@")+7); System.out.println(word); } System.out.println(word); } }} |

我在這里使用了apache公司所提供的jsoup jar包,jsoup 是一款Java 的HTML解析器,可直接解析某個URL地址、HTML文本內容。它提供了一套非常省力的API,可通過DOM,CSS以及類似于jQuery的操作方法來取出和操作數據。

在代碼里,我們可以直接使用Jsoup類,并.出Jsoup的connect()方法,這個方法返回一個org.jsoup.Connection對象,參數則是網站的url地址,Connection對象有一個get()方法返回Document對象

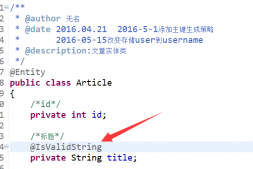

document對象的select方法可以返回一個Elements對象,而Elements對象正式Element對象的集合,但select()方法需要我們傳入一個String參數,這個參數就是我們的選擇器

String selector="div[class=d_post_content j_d_post_content clearfix]";

我們的選擇器語法類似于jquery的選擇器語法,可以選取html頁面中的元素,選擇好后,就可以便利Elements集合,通過Element的text()方法獲取html中的代碼

這樣,一個最簡單的網絡爬蟲就寫完了。

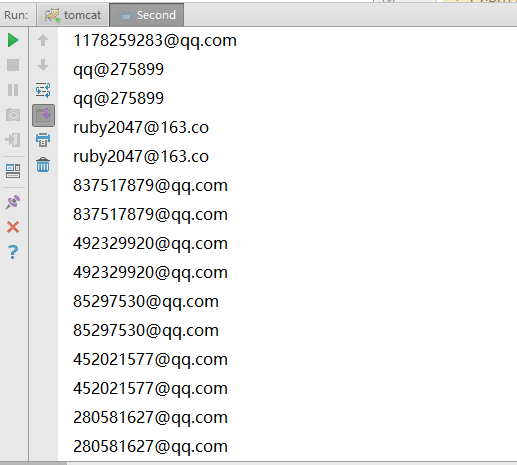

我選擇的網址是 豆瓣網,留下你的郵箱,我會給你發郵件 這樣一個百度貼吧,我扒的是所有人的郵箱地址

附上結果:

以上就是本文的全部內容,希望本文的內容對大家的學習或者工作能帶來一定的幫助,同時也希望多多支持服務器之家!

原文鏈接:http://www.cnblogs.com/yangsongxiao/p/6533558.html