前言

在機器學習中,卷積神經(jīng)網(wǎng)絡(luò)是一種深度前饋人工神經(jīng)網(wǎng)絡(luò),已成功地應用于圖像識別。目前,很多的車牌識號識別,人臉識別等都采用卷積神經(jīng)網(wǎng)絡(luò),可以說卷積神經(jīng)網(wǎng)絡(luò)在圖像識別方面取得了巨大的成功。當前開源的深度學習框架有很多了,比如caffe,tensorflow,torch等,這些深度學習框架包含了完善的卷積神經(jīng)網(wǎng)絡(luò)的實現(xiàn),那么,為什么我們還要自己寫卷積神經(jīng)網(wǎng)絡(luò)?直接用這些開源的深度學習框架多好,又快又省事,性能好穩(wěn)定,bug少。是的,如果你只是使用卷積神經(jīng)網(wǎng)絡(luò)做一些應用,并不在意它的工作原理,那你大可不必自己費神費力的寫卷積神經(jīng)網(wǎng)絡(luò),可如果你想完全掌握卷積神經(jīng)網(wǎng)絡(luò)的工作原理,古人云:紙上得來終覺淺,覺知此時要躬行。所以,你很有必要自己實現(xiàn)一遍卷積神經(jīng)網(wǎng)絡(luò),從而加深對它的認識。

什么是cupcnn

cupcnn是個用java寫的卷積神經(jīng)網(wǎng)絡(luò),我在工作之余,為了加深對卷積神經(jīng)網(wǎng)絡(luò)的認識,實現(xiàn)了它。它足夠簡潔,表現(xiàn)也不錯,非常適合初學者參考使用。它的源碼可以從github下載:cupcnn

你不用擔心它的協(xié)議什么的限制,您可以用它來做任何事,任意修改它,如果它能對你有所幫助,希望能給個星星!!!

^-^^-^^-^

設(shè)計的思路

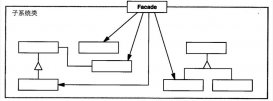

我希望它是以足夠簡單的神經(jīng)網(wǎng)絡(luò),這樣有利于初學者學習。所以我沒有實現(xiàn)那些并發(fā)加速的東西,這保證的代碼的簡介性。設(shè)計的時候,我將卷積神經(jīng)網(wǎng)絡(luò)分為四個模塊:network(layer blob loss active),這點可以從包名中看出來。layer,loss,active都有一個基類,整個神經(jīng)網(wǎng)絡(luò)的編程都是面向基類的。network是綜合這四個模塊,統(tǒng)籌和調(diào)度資源的中心,每個layer都會有一個network的實例,這樣可以輕松的通過network獲得各種數(shù)據(jù),比如獲取每一層的輸出,diff等。

設(shè)計框圖如下:

參數(shù)的保存對于java而言就非常簡單了,實現(xiàn)serializable接口就可以快速實現(xiàn)參數(shù)的序列化和反序列化。cupcnn只對data目錄下的blob和blobparams兩個實現(xiàn)了serializable接口,所有的參數(shù)都由這兩個實現(xiàn)。

目前的表現(xiàn)

全連接神經(jīng)網(wǎng)絡(luò)

目前,在mnist數(shù)據(jù)集上,全連接神經(jīng)網(wǎng)絡(luò)(全連接(100)+全連接(30)+全連接(10)+softmax),訓練30個epoes,準確率為96.76

卷積神經(jīng)網(wǎng)絡(luò)

卷積神經(jīng)網(wǎng)絡(luò)(6個特征)+最大值池化+卷積(6個特征)+全連接(512)+全連接(30)+全連接(10)+softmax),在學習速率為0.2的情況下,訓練30個epoes,準確率為97.79.我相信經(jīng)過進一步參數(shù)調(diào)優(yōu),在充分訓練的情況下,準確率能達到更高。

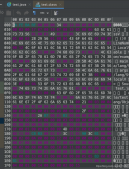

卷積神經(jīng)網(wǎng)絡(luò)訓練快照如下:

begin train

epoe: 0 lossvalue: 2.3019369891560455 lr: 0.2 accuracy is 0.13

epoe: 0 lossvalue: 2.0722489482105195 lr: 0.2 accuracy is 0.44

epoe: 0 lossvalue: 1.2423286194012682 lr: 0.2 accuracy is 0.72

epoe: 0 lossvalue: 0.7860529560675255 lr: 0.2 accuracy is 0.79

epoe: 0 lossvalue: 0.6272194196176664 lr: 0.2 accuracy is 0.87

epoe: 0 lossvalue: 0.5240051326725808 lr: 0.2 accuracy is 0.84

epoe: 0 lossvalue: 0.27637563581928026 lr: 0.2 accuracy is 0.95

epoe: 0 lossvalue: 0.35585388987055083 lr: 0.2 accuracy is 0.92

epoe: 0 lossvalue: 0.441971528417802 lr: 0.2 accuracy is 0.92

epoe: 0 lossvalue: 0.25637710325999674 lr: 0.2 accuracy is 0.95

epoe: 0 lossvalue: 0.39872273532502 lr: 0.2 accuracy is 0.9

epoe: 1 lossvalue: 0.264085484522027 lr: 0.16000000000000003 accuracy is 0.91

epoe: 1 lossvalue: 0.22754066024803088 lr: 0.16000000000000003 accuracy is 0.96

epoe: 1 lossvalue: 0.30256420975577103 lr: 0.16000000000000003 accuracy is 0.96

epoe: 1 lossvalue: 0.18149648622985948 lr: 0.16000000000000003 accuracy is 0.99

epoe: 1 lossvalue: 0.177239938748327 lr: 0.16000000000000003 accuracy is 0.96

epoe: 1 lossvalue: 0.15041993009777443 lr: 0.16000000000000003 accuracy is 0.98

epoe: 1 lossvalue: 0.10759545752665524 lr: 0.16000000000000003 accuracy is 1.0

cupcnn的使用

目前,cupcnn實現(xiàn)了mnist數(shù)據(jù)集上的測試,在src/test下,mnisttest是main函數(shù)的入口,具體的神經(jīng)網(wǎng)絡(luò)的搭建在mnistnetwork類中。在mnistnetwork類中,buildconvnetwork和buildfcnetwork分別實現(xiàn)

了搭建卷積神經(jīng)網(wǎng)絡(luò)和搭建全連接神經(jīng)網(wǎng)絡(luò)。得益于java良好的跨平臺屬性,你下載完cupcnn的源碼后,使用eclipse打開該項目,然后直接運行,應該就能開始在mnist數(shù)據(jù)集上訓練和測試了。

構(gòu)建神經(jīng)網(wǎng)絡(luò)

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

public void buildnetwork(){ //首先構(gòu)建神經(jīng)網(wǎng)絡(luò)對象,并設(shè)置參數(shù) network = new network(); network.setbatch(100); network.setloss(new loglikehoodloss()); //network.setloss(new crossentropyloss()); optimizer = new sgdoptimizer(0.2); network.setoptimizer(optimizer); //buildfcnetwork(); buildconvnetwork(); network.prepare();} |

setbatch()函數(shù)設(shè)置一個批次里有多少張圖片。

setloss()設(shè)置要是用的損失函數(shù)。cupcnn實現(xiàn)了交叉熵損失函數(shù)和對數(shù)似然損失函數(shù)。

setoptimizer()設(shè)置要是用的優(yōu)化器。cupcnn只實現(xiàn)了sgd優(yōu)化器,如果您實現(xiàn)了更好的優(yōu)化器,并且愿意提交到cupcnn,那本人深表歡迎。

構(gòu)建全連接神經(jīng)網(wǎng)絡(luò)

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

private void buildfcnetwork(){ //給network添加網(wǎng)絡(luò)層 inputlayer layer1 = new inputlayer(network,new blobparams(network.getbatch(),1,28,28)); network.addlayer(layer1); fullconnectionlayer layer2 = new fullconnectionlayer(network,new blobparams(network.getbatch(),784,1,1)); layer2.setactivationfunc(new reluactivationfunc()); network.addlayer(layer2); fullconnectionlayer layer3 = new fullconnectionlayer(network,new blobparams(network.getbatch(),100,1,1)); layer3.setactivationfunc(new reluactivationfunc()); network.addlayer(layer3); fullconnectionlayer layer4 = new fullconnectionlayer(network,new blobparams(network.getbatch(),30,1,1)); layer4.setactivationfunc(new sigmodactivationfunc()); network.addlayer(layer4); fullconnectionlayer layer5 = new fullconnectionlayer(network,new blobparams(network.getbatch(),10,1,1)); layer5.setactivationfunc(new reluactivationfunc()); network.addlayer(layer5); softmaxlayer sflayer = new softmaxlayer(network,new blobparams(network.getbatch(),10,1,1)); network.addlayer(sflayer);} |

正如上面代碼展示的一樣,每一個layer都需要一個network,它是network的實例,network是全局的管理者和資源的調(diào)度者,有了network的引用,我們可以輕易的獲得到每一層的輸出的數(shù)據(jù),輸出的誤差等。此外,每一層都需要一個指定當前層輸出數(shù)據(jù)塊大小的參數(shù),該參數(shù)告訴某一層你需要輸出多少數(shù)據(jù)。比如神經(jīng)網(wǎng)絡(luò)的最后一層是softmaxlayer ,它需要輸出到底是哪個數(shù)字,這個數(shù)字用長度為10的向量表示,比如數(shù)字7,那么softmaxlayer 應該輸出第8個元素的值為1,其他元素的值為0。卷積層和池化層需要更多的參數(shù),因為他們都有一個kernel,對卷積層而言,它叫卷積核,卷積層的實現(xiàn)每此每個方向的stride也就是步長都是1,這點還有改進的余地。對于池化層,你出來需要傳入池化核的參數(shù)外,還需要傳入水平方向和垂直方向的步長,這是必須的。

訓練和測試

搭建好神經(jīng)網(wǎng)絡(luò)后,你需要調(diào)用network.prepare()方法,該方法會根據(jù)每一層的數(shù)據(jù)參數(shù)創(chuàng)建輸出數(shù)據(jù)塊和誤差數(shù)據(jù)塊。因此該方法的調(diào)用是必須的。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

|

public void train(list<digitimage> imglist,int epoes){ system.out.println("begin train"); int batch = network.getbatch(); double loclalr = optimizer.getlr(); for(int e=0;e<epoes;e++){ collections.shuffle(imglist); for(int i=0;i<imglist.size()-batch;i+=batch){ list<blob> inputandlabel = buildblobbyimagelist(imglist,i,batch,1,28,28); double lossvalue = network.train(inputandlabel.get(0), inputandlabel.get(1)); if(i>batch && i/batch%50==0){ system.out.print("epoe: "+e+" lossvalue: "+lossvalue+" "+" lr: "+optimizer.getlr()+" "); testinner(inputandlabel.get(0), inputandlabel.get(1)); } } if(loclalr>0.001){ loclalr*=0.8; optimizer.setlr(loclalr); } }}public void test(list<digitimage> imglist){ system.out.println("begin test"); int batch = network.getbatch(); int correctcount = 0; int i = 0; for(i=0;i<imglist.size()-batch;i+=batch){ list<blob> inputandlabel = buildblobbyimagelist(imglist,i,batch,1,28,28); blob output = network.predict(inputandlabel.get(0)); int[] caloutlabels = getbatchoutputlabel(output.getdata()); int[] reallabels = getbatchoutputlabel(inputandlabel.get(1).getdata()); for(int kk=0;kk<caloutlabels.length;kk++){ if(caloutlabels[kk] == reallabels[kk]){ correctcount++; } } } double accuracy = correctcount/(1.0*i+batch); system.out.println("test accuracy is "+accuracy+" correctcount "+correctcount);} |

如上,調(diào)用network的 train即可訓練,調(diào)用network的predict方法即可測試。

參數(shù)的保存和加載

|

1

2

3

4

5

6

7

8

9

|

public void savemodel(string name){ network.savemodel(name);}public void loadmodel(string name){ network = new network(); network.loadmodel(name); network.prepare();} |

調(diào)用network的savemodel和loadmodel可分別實現(xiàn)參數(shù)的保存和加載,你只需要傳入一個文件名即可。當我們通過保存的參數(shù)創(chuàng)建神經(jīng)網(wǎng)絡(luò)的時候,我們需要先new 一個network,然后調(diào)用這個network的loadmodel加載已保存的參數(shù),然后不要忘記調(diào)用prepare方法創(chuàng)建每一層的輸出數(shù)據(jù)塊和誤差數(shù)據(jù)塊。

目前的完成情況及未來的計劃

目前,實現(xiàn)的層有:全連接,卷積,最大值池化層,平均值池化層,softmax層。實現(xiàn)的激活函數(shù)有:sigmod,tanh,relu.

實現(xiàn)的損失函數(shù)有:交叉熵,對數(shù)似然。實現(xiàn)的優(yōu)化為:sgd。參數(shù)已經(jīng)能save和load.接下來會添加droupout層,還會嘗試添加cifar-10上的例子。

此外,我會寫一些文章,回顧自己寫cupcnn過程中的思考可問題,供初學者參考,大神請繞道。感興趣的可以繼續(xù)關(guān)注,希望對大家的學習有所幫助,也希望大家多多支持服務器之家。

原文鏈接:https://blog.csdn.net/u011913612/article/details/79253450