hive的表數據是可以同步到impala中去的。一般impala是提供實時查詢操作的,像比較耗時的入庫操作我們可以使用hive,然后再將數據同步到impala中。另外,我們也可以在hive中創建一張表同時映射hbase中的表,實現數據同步。

下面,筆者依次進行介紹。

一、impala與hive的數據同步

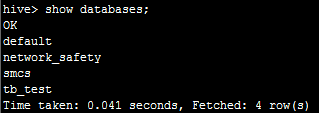

首先,我們在hive命令行執行showdatabases;可以看到有以下幾個數據庫:

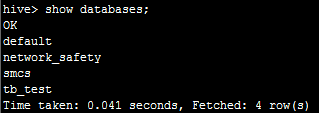

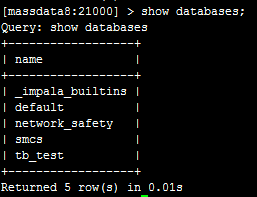

然后,我們在impala同樣執行showdatabases;可以看到:

目前的數據庫都是一樣的。

下面,我們在hive里面執行create databaseqyk_test;創建一個數據庫,如下:

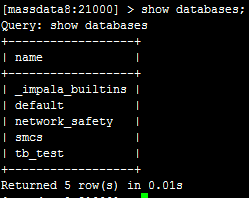

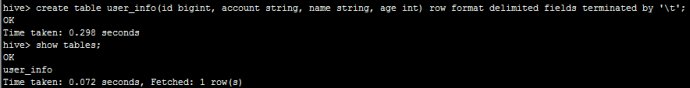

然后,我們使用qyk_test這個數據庫創建一張表,執行create table user_info(idbigint, account string, name string, age int) row format delimitedfields terminated by ‘\t';如下:

此時,我們已經在hive這邊創建好了,然后直接在impala這邊執行showdatabases;可以看到:

連qyk_test這個數據庫都沒有。

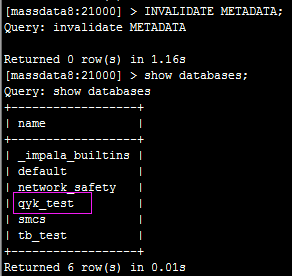

接下來,我們在impala執行invalidatemetadata;然后再查詢可以看到:

數據庫和表都會同步過來。

好了,筆者來做個總結:

如果在hive里面做了新增、刪除數據庫、表或者數據等更新操作,需要執行在impala里面執行invalidatemetadata;命令才能將hive的數據同步impala;

如果直接在impala里面新增、刪除數據庫、表或者數據,會自動同步到hive,無需執行任何命令。

二、hive與hbase的數據同步

首先,我們在hbase中創建一張表create ‘user_sysc', {name =>‘info'},然后,我們在hive中執行

|

1

2

3

4

|

createexternaltableuser_sysc(keyint,valuestring)rowformatserde 'org.apache.hadoop.hive.hbase.hbaseserde'stored by'org.apache.hadoop.hive.hbase.hbasestoragehandler'withserdeproperties( 'serialization.format'='\t','hbase.columns.mapping'=':key,info:value','field.delim'='\t')tblproperties ('hbase.table.name'='user_sysc') |

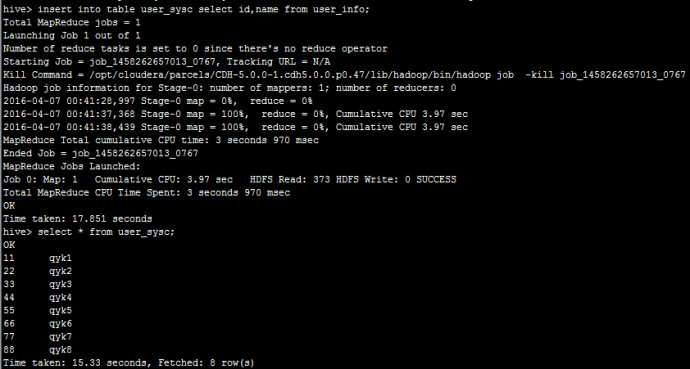

創建一張外部表指向hbase中的表,然后,我們在hive執行insert into tableuser_sysc select id,name fromuser_info;入一步份數據到user_sysc可以看到:

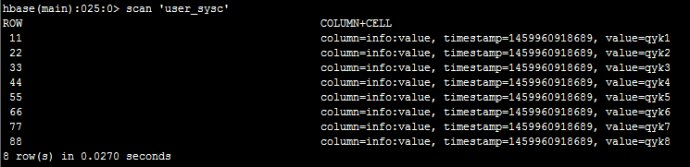

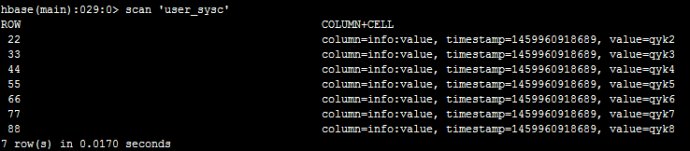

然后,我們在hbase里面執行scan‘user_sysc'可以看到:

接下來,我們在hbase里面執行deleteall ‘user_sysc',‘11'刪掉一條數據,如下:

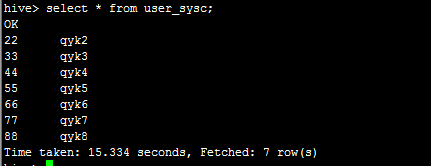

然后,我在hive里面查詢看看,如下:

說明自動同步過來了。因此,只要創建hive表時,與hbase中的表做了映射,表名和字段名可以不一致,之后無論在hbase中新增刪除數據還是在hive中,都會自動同步。

如果在hive里面是創建的外部表需要在hbase中先創建,內部表則會在hbase中自動創建指定的表名。

因為hive不支持刪除等操作,而hbase里面比較方便,所以我們可以采用這種方式。

原文鏈接:http://blog.sina.com.cn/s/blog_9c6852670102wwyr.html